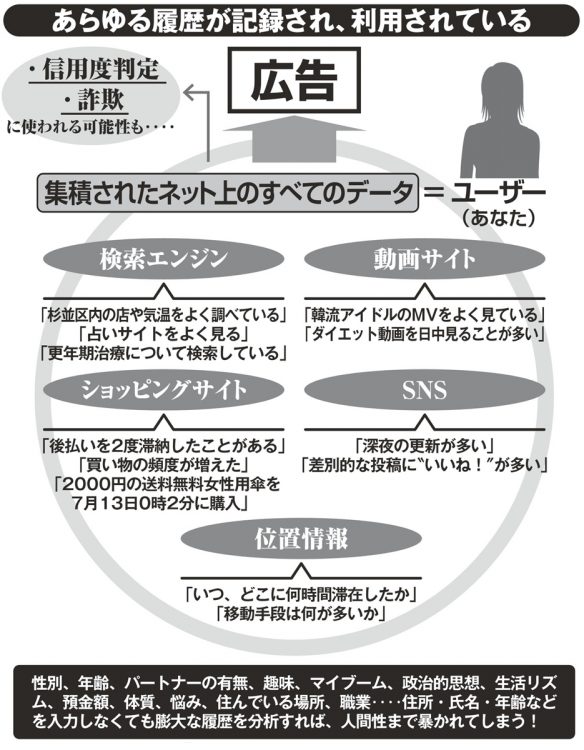

あらゆる履歴が記録され、利用されている

Amazonの人材採用システムがお蔵入りしたワケ

アメリカでは、犯罪予測や保険金の支払いにもAIによるビッグデータ分析が利用されており、これがすでにバーチャル・スラムを招いている。

長い間黒人が不当に差別されてきたアメリカでは、黒人の検挙の記録が多く残されている。その「古い」データから学習したAIは「黒人=犯罪率が高い」と判断してしまう。それをもとに警察が捜査すると、黒人であるというだけで疑われてしまう。まるで1950年代に戻ったかのような差別が再生産されるのだ。

2018年のロイター通信によると、AmazonがAIを使った人材採用システムを開発したが、試験運用の段階で、ある大きな欠陥が判明し、システムはお蔵入りとなった。

「性別に関する情報は、システムに直接は入れていませんでした。しかし、履歴書の中に“○○女子校”など、女性と関連する単語があると、AIが評価を下げていたのです。AIが参照したデータに、働く女性が少ない時代のものが入り込んでいたため、“女性=劣った存在”と学習してしまった。AIは、過去のデータを“食べて”学習します。その中に、マイノリティーへの差別や偏見が含まれていると、それも無邪気に取り込んで、差別的な構造を継承してしまう」(山本さん・以下同)

ゆがんだ思想が正当化されるのは、AIだけではない。SNS上では、自分が気に入ってフォローしている人の言葉と、自分好みの広告しか目に入らない。こうした、好みのモノだけに囲まれた状態のことを「フィルターバブル」という。

「フィルターバブルの中にいると、自分好みの言葉や思想を繰り返し目にすることで、思想が過激化していく。さまざまな思想を持つ人がそれぞれ過激化していくため、ネット上ではしばしば殺伐とした、感情的な抗争が起こります。思想の分断が激しくなり、民主主義の崩壊にもつながりかねません」

もしAIを妄信すれば、人類はまた、差別や偏見、争いの歴史を繰り返すことになるかもしれない。

文/角山祥道 取材/進藤大郎、土屋秀太郎、平田淳

※女性セブン2022年8月11日号